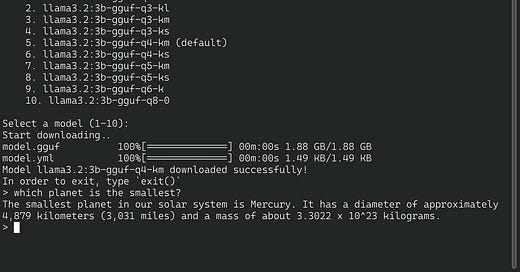

Cortex (github.com/janhq/cortex.cpp) punya mesin inferensi yang banyak: llama.cpp, ONNX, sama TensorRT-LLM. Makainya juga gampang:

cortex start

cortex pull llama3.2

cortex run llama3.2

Langsung dah kita bisa chat.

Kenapa nggak pakai Ollama? Secara pribadi, saya kurang respek sama Ollama. Pasalnya, mesin inferensi yang digunakan Ollama di belakang layar adalah llama.cpp. Anggap Ollama adalah llama.cpp yang dibungkus rapi, gampang diinstal, update, dll.

Tapi awalnya Ollama segan "mengakui" keberadaan llama.cpp yang jadi mesin inferensinya. Begitu banyak yang protes, eh setelah 10 bulan baru deh nongol kreditnya di README. (Sumber: Ollama commit 9755cf917).

Terlepas dari lebih suka Cortex atau Ollama, kalau baru pertama kali mau nyoba LLM, pakai Llamafile aja. Lebih rincinya dibahas di sini: Berkenalan dengan LLM.

Tip ini pernah saya utarakan sebelumnya sebagai sebuah utas di Threads.