Menyundul LLM dengan Contoh Nyata

Dalam dunia perkodingan LLM, sering dijumpai istilah zero-shot vs few-shot prompt. Yang terakhir juga biasanya di sekitar tajuk in-context learning (ICL).

Sebenarnya, ini adalah bagian dari seni nge-prompt, yakni menjebloskan perintah tertentu dan ditandai sebagai "system" (di sini asalnya istilah "system prompt").

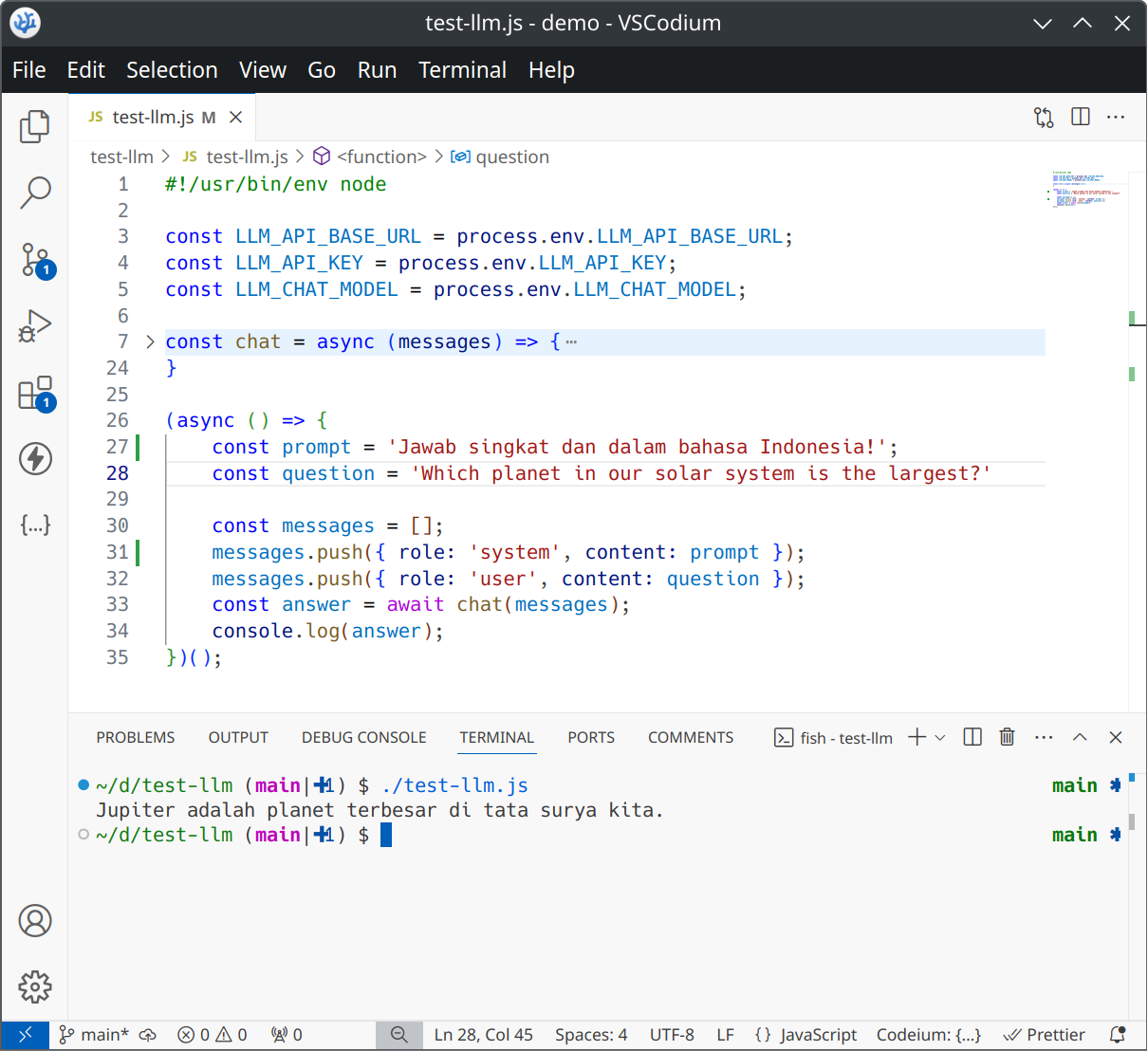

Begini contoh prompt yang sangat bersahaja. Coba sendiri, hasilnya adalah jawaban yang pendek, sesuai perintah (atasan).

Bila masih asing dengan kode JavaScript tersebut, ini adalah cara nembak API sebuah LLM secara sangat minimalis. Lengkapnya bisa dicerna dari tulisan saya sebelumnya, Mufakat dalam Merangkul LLM.

Buat yang nggak nge-fans sama JavaScript, jangan pening. Konsep yang sama juga berlaku kalau ngoding pakai bahasa lain. Yang penting, perhatikan array messages dalam cuplikan kode tersebut.

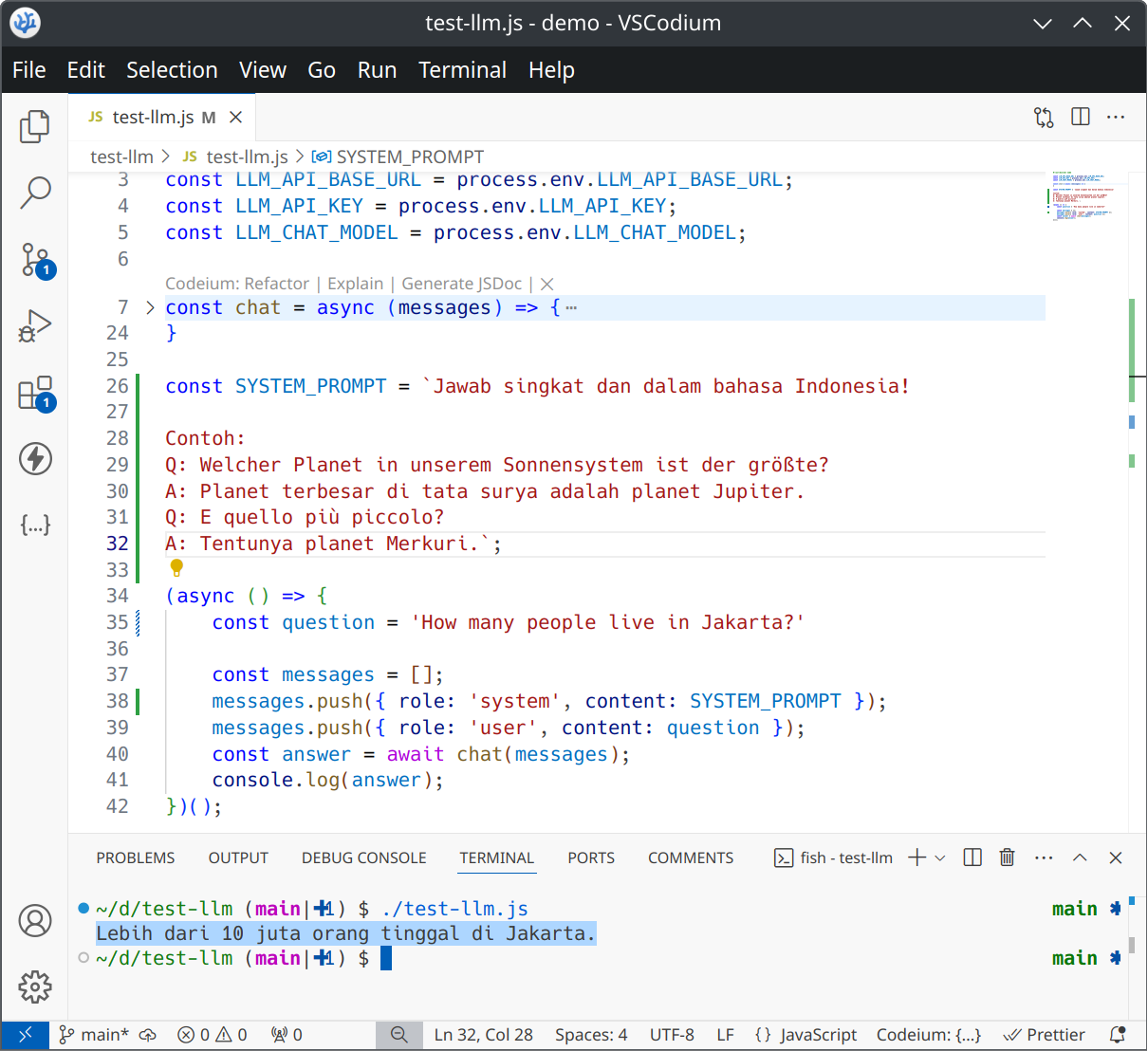

Untuk teknik few-shot, beda lagi triknya.

Di sini perintah (atasan) saja tidak cukup. Harus ada contoh-contoh yang nyata (sepasang Q & A, dalam tangkapan layar berikut). Sejumlah contoh tersebut yang akan menyundul si LLM supaya lebih taat lagi.

Landasan berpikir dengan ICL (in-context learning) akan sangat berfaedah, ketika kita akan terjun ke dunia CoT (chain-of-thought) dan juga nantinya RAG (Retrieval-Augmented Generation).

Sesuai tulisan saya sebelumnya, menyoroti yang terjadi di balik layar bakal sangat menolong untuk mencermati tahapan belajar berikutnya. Ini yang hilang, kalau belum-belum sudah main LangChain (atau framework lain), Nembak API untuk LLM: Cepat dan Tangkas.

Sekali lagi, contoh lengkapnya (dalam JavaScript, Python, Clojure, Go, atau Swift) bisa juga dinikmati di demo sederhana di github.com/ariya/ask-llm.

Tulisan ini disadur dari utas saya sebelumnya di Threads.